スケーリング(Scaling)

スケーリング(Scaling)とは、データの値の範囲や分布を一定の基準に変換する前処理手法のことです。

機械学習の多くのアルゴリズム(例:線形回帰、SVM、ニューラルネットワークなど)は、入力データのスケール(値の大きさ)が異なると学習が遅くなったり、うまく収束しなかったりします。そのため、データの特徴量を適切にスケーリングすることが重要です。

代表的な方法には以下があります。

-

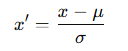

標準化(Standardization)

平均を0、分散を1に変換(Zスコア正規化) 主に正規分布に近いデータに有効。

主に正規分布に近いデータに有効。 -

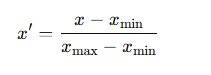

最小最大正規化(Min-Max Scaling)

値を0〜1などの指定範囲に変換 ニューラルネットワークなどに広く利用。

ニューラルネットワークなどに広く利用。 -

ロバストスケーリング(Robust Scaling)

中央値と四分位範囲を使い外れ値の影響を減らす方法。スケーリングを行うことで勾配降下法の収束が早まり、重みの更新が安定します。特に深層学習では、活性化関数(ReLUやSigmoid)が極端な値で飽和するのを防ぐ効果もあります。

スケーリング(Scaling)関連用語

スケーリング(Scaling)に関連する単語は以下の通りです。

- 正規化(Normalization)

- 勾配降下法(Gradient Descent)

- 活性化関数(Activation Function)

スケーリング(Scaling)やさしい解説

スケーリング(Scaling)は、「数字の大きさをそろえる作業」です。

例えば、身長(150〜180cm)と体重(40〜80kg)をそのまま使うと、体重よりも身長の数字が大きいので、AIは「身長のほうが重要」と勘違いしやすくなります。

そこで、両方の数字を0〜1の間にそろえるとAIは公平にデータを見られるようになります。これは、スポーツ大会で体重別や年齢別にクラスを分けるのと似ています。

AI関連の用語集【まとめ】

AI関連の用語集が気になる方のために、用語集一覧を作成しました。AIに関する学びを深めたいとお考えの方はぜひご覧ください。

\AIの導入・開発・相談なら【クラベルAI】に相談しよう!/

-AI関連の用語集【クラベルAI】-29.jpg)