ショートQ&Aコーナー

- Q:生成AIにはどんな危険性がある?

A:情報漏えいのリスクや嘘の情報を生成するリスクなどさまざま。 - Q:生成AIの危険から身を守るための対策は?

A:個人情報や機密情報は絶対に入力しないことやファクトチェックをすることなど。

ChatGPTをはじめとする生成AIは、私たちの仕事や生活を大きく変える可能性を秘めています。

その一方で、「情報漏えい」や「著作権」といった危険性も指摘されており、利用に不安を感じる方も多いのではないでしょうか?

この記事では、生成AIに潜む主なリスクを7つに整理し、個人と企業がそれぞれ取るべき安全対策を具体的に解説します。

漠然とした不安を解消し、AIを安全なパートナーにするために、ぜひご一読ください。

まずは、生成AIの主な危険性(リスク)からみていきましょう。

目次

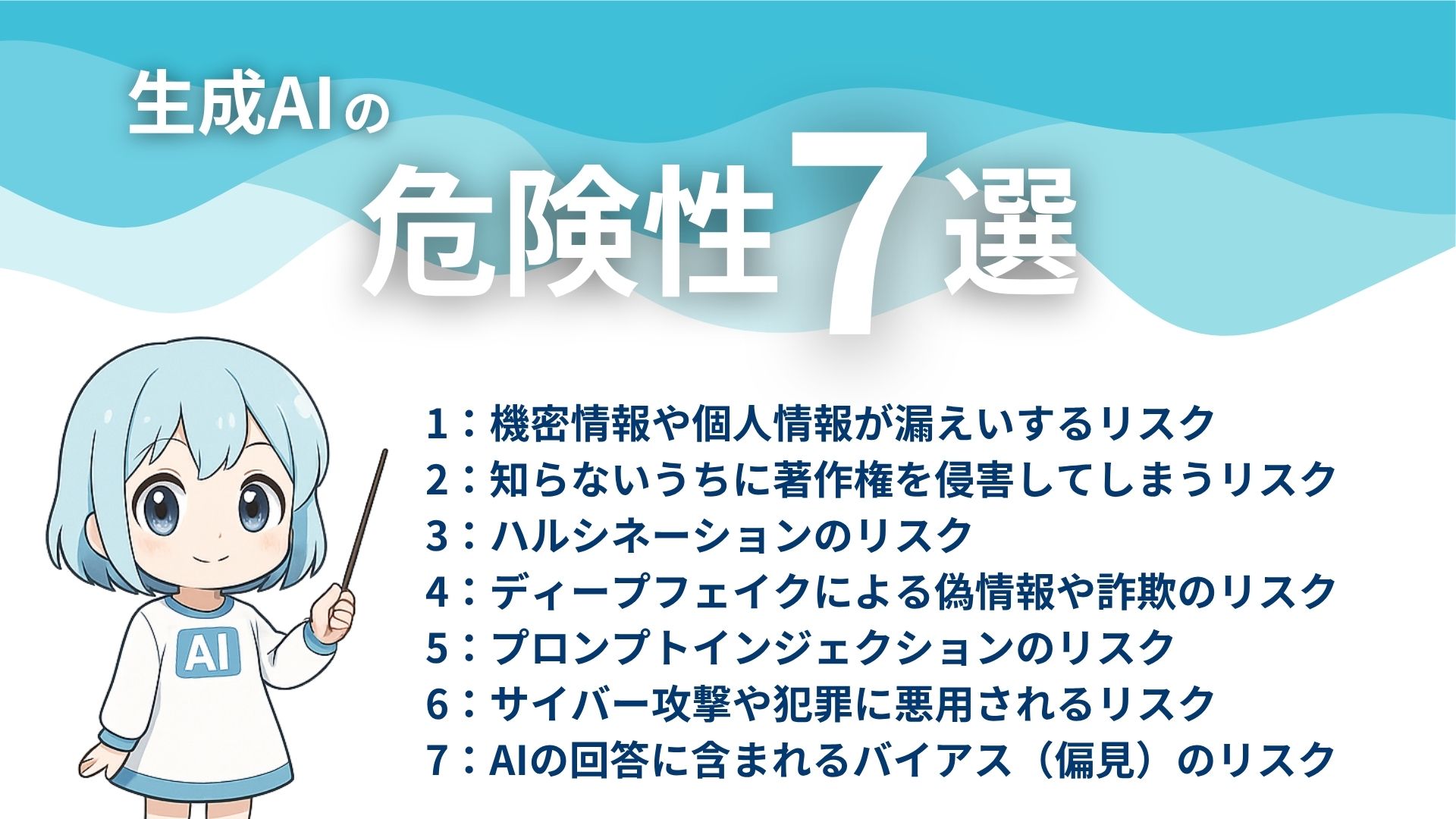

生成AIの主な危険性(リスク)7選

生成AIは非常に便利なツールですが、その利用には注意すべき危険性が存在します。

ビジネスや個人で安全に活用するためには、まずどのようなリスクがあるのかを正確に把握することが重要です。

ここでは、生成AIに潜む主な7つの危険性を解説します。

生成AIの主な危険性

- 機密情報や個人情報が漏えいするリスク

- 知らないうちに著作権を侵害してしまうリスク

- AIが嘘をつく「ハルシネーション」のリスク

- 「ディープフェイク」による偽情報や詐欺のリスク

- 意図しない情報を引き出す「プロンプトインジェクション」のリスク

- サイバー攻撃や犯罪に悪用されるリスク

- AIの回答に含まれるバイアス(偏見)のリスク

これらの危険性は、知らないうちに加害者や被害者になる可能性があるものです。

しかし、一つひとつのリスクを理解すれば、事前に対策を立てられます。

これらの危険性から身を守るための具体的な方法をみていきましょう。

危険性1:機密情報や個人情報が漏えいするリスク

生成AIの危険性1つ目は、機密情報や個人情報が漏えいするリスクです。

多くの生成AIは、入力された情報を学習データとして利用するためです。

例えば、社外秘の会議内容や顧客リストを入力すると、その情報がAIの学習に使われます。

そして、他のユーザーへの回答として外部に漏えいする恐れがあるのです。

したがって、生成AIには機密情報や個人情報を入力してはいけません。

.png)

危険性2:知らないうちに著作権を侵害してしまうリスク

生成AIの危険性2つ目は、知らないうちに著作権を侵害してしまうリスクです。

生成AIが生成したコンテンツは、意図せず著作権を侵害する可能性があります。

これは、AIがインターネット上の膨大な情報を学習データにしているためです。

学習データに既存の著作物が含まれている場合、AIの生成物がそれに酷似することがあります。

その生成物を知らずに商用利用すれば、著作権侵害を問われるかもしれません。

そのため、生成AIの生成物は、利用前に必ず人の目で確認する必要があります。

.png)

危険性3:AIが嘘をつく「ハルシネーション」のリスク

生成AIの危険性3つ目は、AIが嘘をつく「ハルシネーション」のリスクです。

生成AIは、事実に基づかないもっともらしい嘘の情報を生成することがあります。

この現象は「ハルシネーション」と呼ばれ、AIが誤った学習をしたり、情報を関連付けたりすることで発生します。

例えば、実在しない事件や論文を、さも事実であるかのように記述することがあります。

生成AIから得た情報は鵜呑みにせず、必ず一次情報で事実確認することが大切です。

.png)

危険性4:「ディープフェイク」による偽情報や詐欺のリスク

生成AIの危険性4つ目は「ディープフェイク」による偽情報や詐欺のリスクです。

生成AIは、ディープフェイクと呼ばれる精巧な偽動画や偽音声を作成できてしまいます。

この技術は、特定の人物が言ってもいないことを話しているかのように見せることが可能です。

例えば、有名人や政治家をかたった偽の動画で、世論を操作するような事態も起こりえます。

また、詐欺への悪用も懸念されるため、生成AIによって作られたコンテンツには注意が必要です。

.png)

危険性5:意図しない情報を引き出す「プロンプトインジェクション」のリスク

生成AIの危険性5つ目は、意図しない情報を引き出す「プロンプトインジェクション」のリスクです。

プロンプトインジェクションとは、攻撃者が巧妙な指示(プロンプト)を与えることで、AIの制約を回避する攻撃手法です。

この攻撃を受けると、AIは本来開示すべきでない機密情報や、有害なコンテンツを生成する恐れがあります。

そのため、開発者は対策を講じていますが、利用者側もこのような危険性があることを知っておくべきです。

.png)

危険性6:サイバー攻撃や犯罪に悪用されるリスク

生成AIの危険性6つ目は、サイバー攻撃や犯罪に悪用されるリスクです。

生成AIは、サイバー攻撃や犯罪のツールとして悪用される危険性をはらんでいます。

なぜなら、専門知識がない人でも、AIを使えば悪意のあるプログラムを作成できるためです。

例えば、フィッシング詐欺の巧妙なメール文面を大量に作ったり、コンピューターウイルスを開発させたりする事例が報告されています。

このように、生成AIは犯罪のハードルを下げる可能性があるのです。

.png)

危険性7:AIの回答に含まれるバイアス(偏見)のリスク

生成AIの危険性7つ目は、AIの回答に含まれるバイアス(偏見)のリスクです。

AIはインターネット上の情報を学習するため、データに含まれる社会的な偏見もそのまま学習してしまうのです。

例えば、特定の職種を特定の性別と結びつけて表現するようなケースが考えられます。

このような偏った情報をもとに判断を下さないよう、生成AIの回答を多角的に検証することが求められます。

.png)

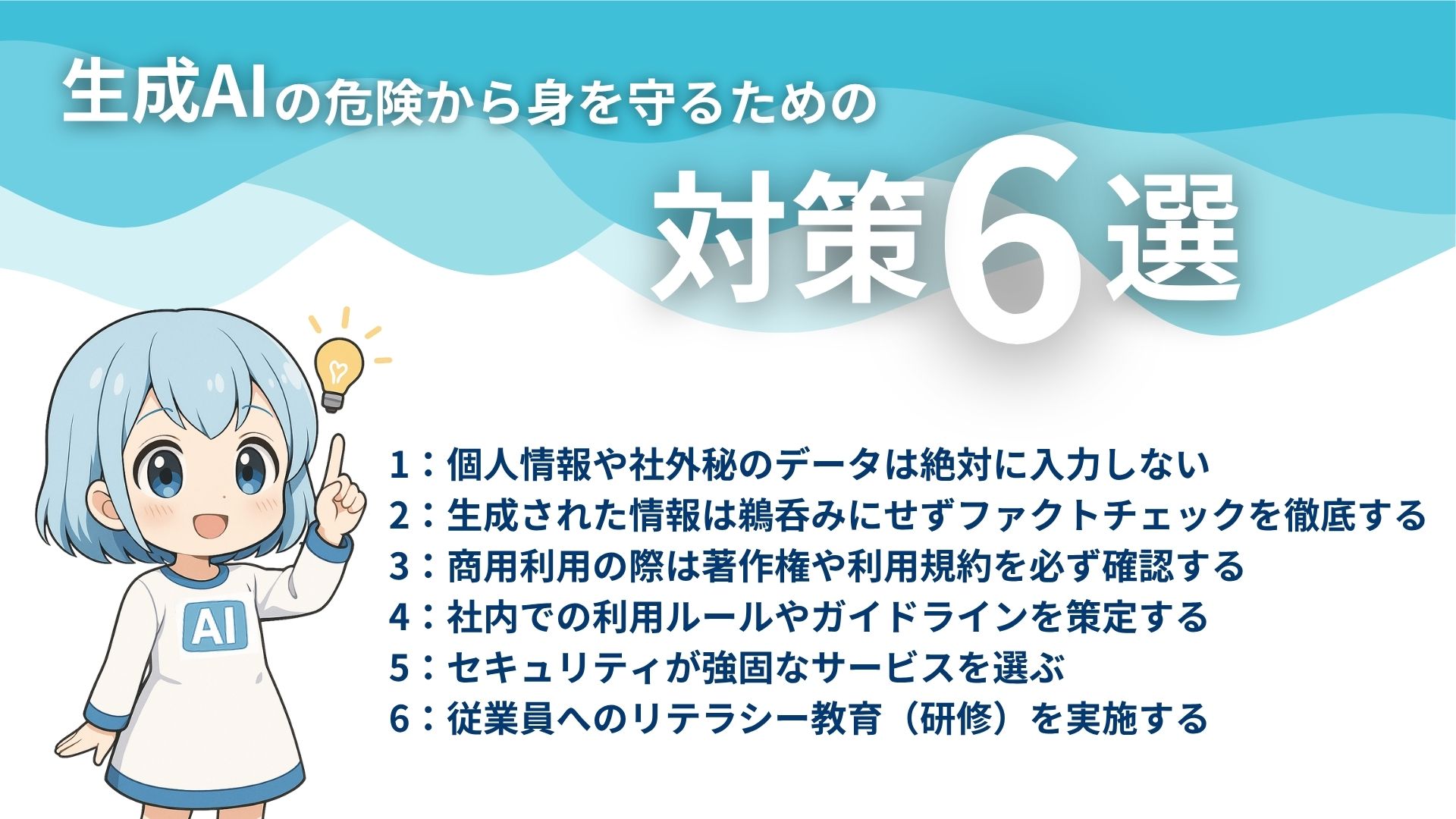

生成AIの危険から身を守るための対策6選

生成AIに潜む危険性を理解したうえで、次に具体的な対策を講じることが重要になります。

対策は決して難しいものばかりではありません。

個人で今日から実践できることから、法人として組織的に取り組むべきことまでさまざまです。

ここでは、個人と法人、それぞれの立場で実施すべき対策を解説します。

生成AIの危険から身を守るための対策

- 個人情報や社外秘のデータは絶対に入力しない

- 生成された情報は鵜呑みにせずファクトチェックを徹底する

- 商用利用の際は著作権や利用規約を必ず確認する

- 社内での利用ルールやガイドラインを策定する

- セキュリティが強固なサービスを選ぶ

- 従業員へのリテラシー教育(研修)を実施する

これらの対策を実践することで、生成AIの危険性を大幅に減らせるでしょう。

順番に解説していきます。

対策1:個人情報や社外秘のデータは絶対に入力しない

生成AIの危険から身を守るための対策1つ目は、個人情報や社外秘のデータは絶対に入力しないことです。

入力されたデータはAIの学習に利用され、外部に漏えいするリスクがあるためです。

具体的には、氏名や住所などの個人情報、企業の財務データや開発情報などが該当します。

生成AIは便利なツールですが、情報漏洩の危険性を常に意識し、入力する情報には細心の注意を払うべきです。

.png)

対策2:生成された情報は鵜呑みにせずファクトチェックを徹底する

生成AIの危険から身を守るための対策2つ目は、生成された情報は鵜呑みにせずファクトチェックを徹底することです。

なぜなら、AIはハルシネーションにより、誤った情報を生成する場合があるためです。

例えば、レポートや記事にAIの回答を引用する際は、必ず公的な統計や専門サイトで裏付けを取りましょう。

生成AIはあくまで思考の補助ツールと位置づけ、情報の正しさは人間が担保する必要があります。

.png)

対策3:商用利用の際は著作権や利用規約を必ず確認する

生成AIの危険から身を守るための対策3つ目は、商用利用の際に著作権や利用規約を必ず確認することです。

AIの生成物が他者の著作権を侵害している可能性があるためです。

各サービスは、生成物の商用利用に関する独自の規約を設けています。

トラブルを避けるためにも、それらの規約を熟読し、許諾範囲を正しく理解したうえで利用することが重要です。

.png)

対策4:社内での利用ルールやガイドラインを策定する

生成AIの危険から身を守るための対策4つ目は、社内での利用ルールやガイドラインを策定することです。

企業として生成AIを導入する場合、まず社内ガイドラインを策定しましょう。

従業員が個人の判断で利用すると、情報漏えいなどの重大な事故につながりかねません。

ガイドラインでは、入力してはいけない情報の定義や、業務での利用範囲を明確に定めます。

全社で統一されたルールを設けることが、安全な活用の第一歩となります。

.png)

対策5:セキュリティが強固なサービスを選ぶ

生成AIの危険から身を守るための対策5つ目は、セキュリティが強固なサービスを選ぶことです。

特に、ビジネスで生成AIを利用するなら、セキュリティ機能が充実した法人向けサービスを選びましょう。

法人向けプランは、入力したデータがAIの学習に使われないよう設定できるものが多くあります。

また、アクセス管理やログ監視機能など、企業統治に必要な機能も備わっています。

初期費用はかかりますが、情報資産を守るためには不可欠な投資といえるでしょう。

.png)

対策6:従業員へのリテラシー教育(研修)を実施する

生成AIの危険から身を守るための対策6つ目は、従業員へのリテラシー教育(研修)を実施することです。

ルールを作るだけでは、その背景にある危険性への理解が浸透しないためです。

研修では、具体的な事故事例を交えながら、生成AIの危険性や正しい利用法を周知しましょう。

全従業員のITリテラシーを向上させることが、組織全体のリスク管理につながります。

.png)

生成AIを安全に導入するなら専門家への相談もおすすめ

ここまで解説した対策を実行するのが難しい、あるいは何から手をつければよいかわからない場合もあるでしょう。

特に、ビジネスにおける生成AIの活用は、単なるリスク管理に留まりません。

業務効率化や新規事業創出といった攻めの活用まで見据えるなら、専門家の知見を借りるのが賢明です。

AI活用の第一相談所を担う「クラベルAI」では、AIの活用を考えている方と専門家とのマッチングサービスを展開しています。

AI活用における「誰に・何を・どう聞けばいいの?」というところからAIを使った大規模開発まで、何度でも無料で相談可能。

AI活用のことで何か気になることがある方は今すぐ無料相談をご活用ください。

なお、電話相談(03-6826-0562)も可能です。

.png)

生成AIの危険性を正しく理解し強力なパートナーにしよう

生成AIは、情報漏洩や著作権侵害、偽情報の拡散など、さまざまなリスクを内包しています。

しかし、これらの危険性は、利用者が正しい知識を持つことで、その多くを回避することが可能です。

個人情報の不入力やファクトチェックといった基本的なルールを守り、企業であればガイドライン策定や社員教育を徹底することが、安全な活用の大前提となります。

もし自社での導入や運用に不安があれば、専門家への相談も検討しましょう。

クラベルAIでは、AI活用に関する無料相談を受け付けています。

「誰に・何を・どう聞けばいいの?」というところからAIを使った大規模開発まで、何度でも無料で相談できるので、AI活用をお考えの方はぜひ一度お問い合わせください。

生成AIの危険性に関するよくある質問

生成AIのリスク対策にはどのようなものがありますか?

個人でできる対策には、個人情報や機密情報を入力しない、AIの生成情報を鵜呑みにしないなどがあります。法人での対策としては、社内ガイドラインの策定やセキュリティの高いツールの導入が挙げられます。利用者の立場に応じて、適切なリスク対策を講じることが大切です。

生成AIを企業で導入する際に気をつけるポイントはなんですか?

企業で導入する際は、まず利用目的を明確にすることが重要です。そのうえで、情報漏えい対策として厳格なガイドラインを策定し、全従業員に周知徹底する必要があります。また、費用対効果や既存システムとの連携も考慮し、自社に合ったツールを慎重に選定する視点が欠かせません。

\AIの導入・開発・相談なら【クラベルAI】に相談しよう!/