ショートQ&Aコーナー

- Q:なぜ今生成AIの倫理問題に注目すべき?

A:生成AIの技術発展に法整備が追いついていないから。 - Q:生成AIの主要な倫理問題は?

A:著作権・知的財産権の侵害リスクや個人情報や機密情報の漏えいなど。 - Q:生成AIを安全に活用するために企業が取り組むべきことは?

A:明確な社内ガイドラインを策定したり従業員への教育をしたりなど。

あなたの会社でも、生成AIの活用は進んでいますか?

その便利さの裏に潜む、著作権侵害や情報漏洩といった倫理的な問題に、不安を感じていませんか?

知らないままの利用は、企業の信頼を揺るがす大きなリスクになりかねません。

本記事では、企業が直面する具体的な倫理問題と、それを乗り越えるための安全な活用法をわかりやすく解説します。

リスクを正しく管理し、生成AIの恩恵を最大限に引き出しましょう。

それでは、生成AIの倫理問題に注目すべき理由からみていきましょう。

目次

なぜ今生成AIの倫理問題に注目すべきなのか

生成AIは、多くのビジネス現場で急速に導入が進む身近な技術となりました。

しかし、その手軽さの裏で、深刻な倫理問題が顕在化しているのが現状です。

技術の発展速度に対して法整備が追いついておらず、企業は自らを守る対策が不可欠です。

情報漏洩や著作権侵害などの問題は、一度起これば企業の信頼を大きく損ないます。

だからこそ今、リスクを正しく理解し対策を講じることが企業には求められているのです。

.png)

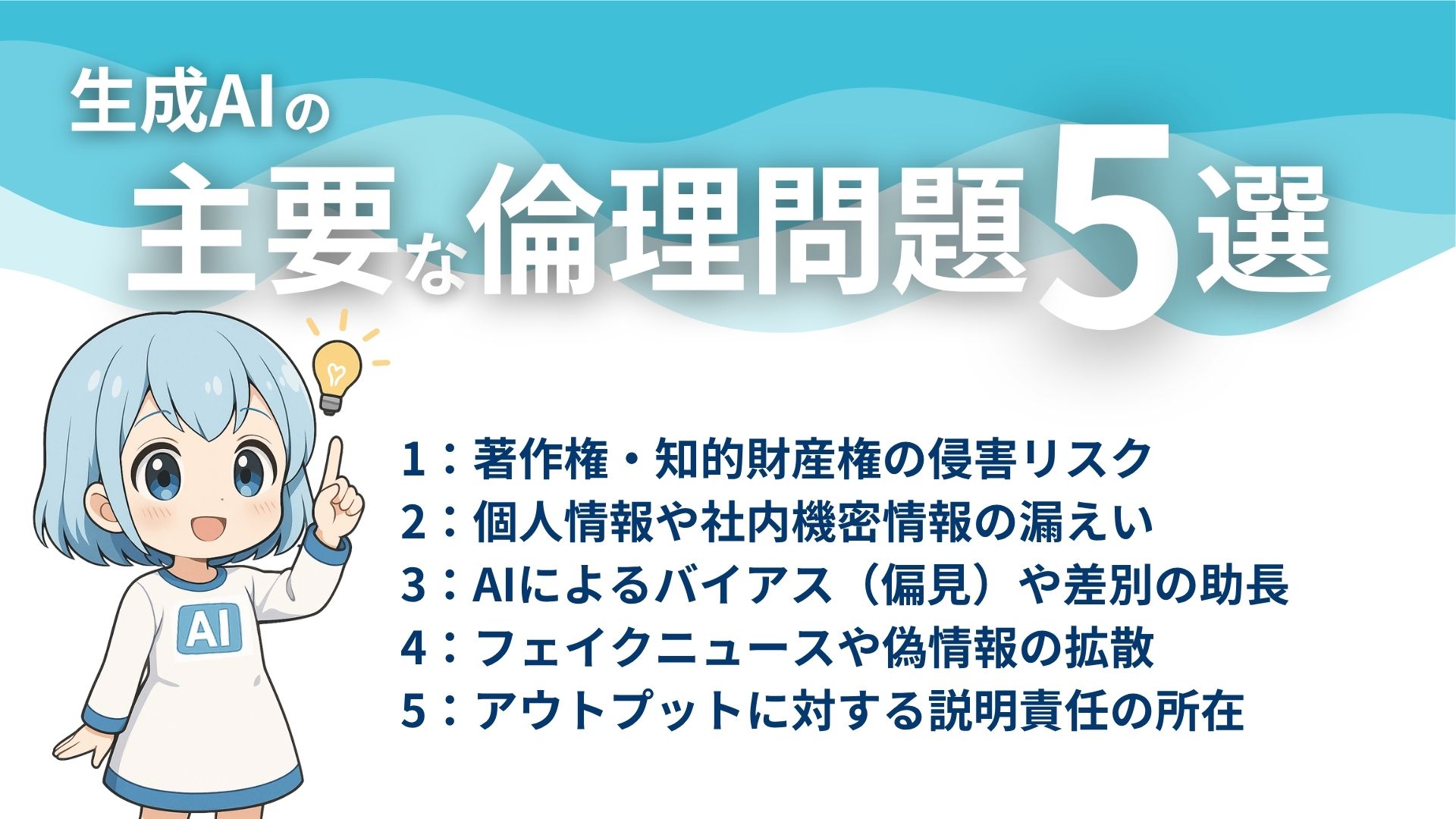

生成AIの主要な倫理問題5選

生成AIの活用には、これまでになかった新たなリスクが伴います。

特に企業が注意すべき倫理的な問題は、著作権侵害から情報漏えい、差別助長まで多岐にわたります。

生成AIの主要な倫理問題

- 著作権・知的財産権の侵害リスク

- 個人情報や社内機密情報の漏えい

- AIによるバイアス(偏見)や差別の助長

- フェイクニュースや偽情報の拡散

- アウトプットに対する説明責任の所在

これから、企業が直面しうる主要な5つの倫理問題を詳しくみていきましょう。

倫理問題1:著作権・知的財産権の侵害リスク

生成AIは、意図せず著作権を侵害してしまう可能性があります。

なぜなら、AIはインターネット上の膨大なデータを学習しているためです。

その中には、著作権で保護されたコンテンツも当然含まれています。

例えば、AIが生成した文章や画像が、既存の作品と酷似するケースです。

そのため、企業は生成AIの成果物について、常に著作権侵害のリスクを認識すべきです。

.png)

倫理問題2:個人情報や社内機密情報の漏えい

生成AIの利用は、情報漏えいという重大な問題を引き起こす危険性があります。

多くの生成AIサービスは、入力情報をAIの学習データに再利用するためです。

従業員が顧客情報や開発中の製品情報をプロンプトに入力する場面を想像してください。

その情報が外部に渡り、意図せず流出してしまう恐れがあります。

企業は生成AIの利用時に、機密情報を入力させないルール徹底が不可欠です。

.png)

倫理問題3:AIによるバイアス(偏見)や差別の助長

生成AIは、学習データに含まれる偏見を助長してしまう問題を持っています。

AI自身は中立ですが、その学習元となるデータには社会的なバイアスが含まれます。

例えば、特定の性別や人種に対する固定観念に基づいた回答を生成する場合があるでしょう。

このようなAIの利用は企業の信頼を損なうため、出力に偏見がないか監視が必要です。

.png)

倫理問題4:フェイクニュースや偽情報の拡散

生成AIは、事実に基づかない偽情報を生成することがあります。

これは「ハルシネーション」と呼ばれ、AIがもっともらしい嘘をつく問題です。

例えば、AIに専門的な内容を質問した際、誤った情報を事実のように回答するケースです。

企業がこの情報を発信すれば大きな問題となるため、生成AIの回答は鵜呑みにできません。

.png)

倫理問題5:アウトプットに対する説明責任の所在

生成AIが問題を起こした場合、その責任の所在が曖昧になる可能性があります。

AIの判断プロセスは複雑で、なぜその結論に至ったのかを説明しきれないためです。

例えば、AIの生成物が他者の権利を侵害した際、誰が責任を負うのかが問題になります。

企業はAIの利用において、最終的な責任は自社にあるという認識を持つべきです。

.png)

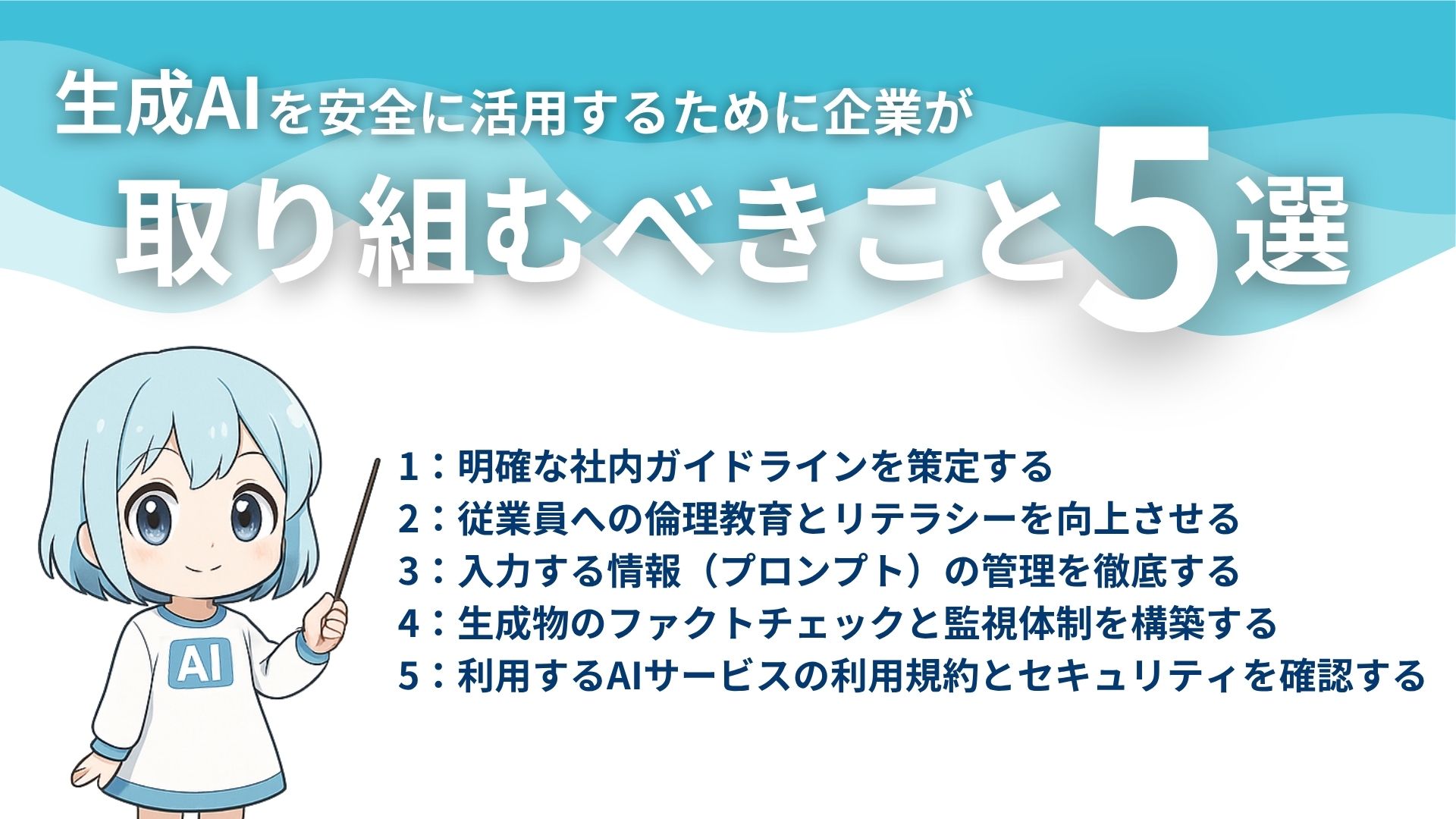

生成AIを安全に活用するために企業が取り組むべきこと5選

これまで見てきたような生成AIの倫理問題は、決して無視できません。

しかし、適切な対策を講じることで、企業はリスクを管理し、安全にAIを活用できます。

ここからは、生成AIを安全に利用するための具体的な方法を解説します。

生成AIの活用で企業が取り組むべきこと

- 明確な社内利用ガイドラインを策定する

- 従業員への倫理教育とリテラシーを向上させる

- 入力する情報(プロンプト)の管理を徹底する

- 生成物のファクトチェックと監視体制を構築する

- 利用するAIサービスの利用規約とセキュリティを確認する

順番にみていきましょう。

1:明確な社内利用ガイドラインを策定する

企業は、生成AIの利用に関する明確なガイドラインを策定すべきです。

従業員が自己判断でAIを利用すると、思わぬ問題に発展する可能性があるためです。

ガイドラインでは、利用目的の範囲や入力禁止情報、生成物の取り扱いなどを定めます。

全社で統一されたルールを持つことが、倫理的な問題を防ぐ第一歩となります。

.png)

2:従業員への倫理教育とリテラシーを向上させる

企業は、従業員に対して生成AIに関する教育を行う必要があります。

多くの従業員は、生成AIの倫理的な問題を十分に理解していない可能性があるでしょう。

研修などを通じて、具体的なリスク事例やガイドラインの内容を周知させることが重要です。

従業員一人ひとりのリテラシー向上が、企業全体のリスク管理につながります。

.png)

3:入力する情報(プロンプト)の管理を徹底する

企業は、生成AIに入力する情報を厳格に管理しなければなりません。

入力情報が外部に漏えいするリスクが存在するためです。

個人情報や顧客情報、社外秘のデータなどは絶対に入力しないよう徹底します。

このような情報管理の徹底は、生成AIを利用する上での最低限の義務といえます。

.png)

4:生成物のファクトチェックと監視体制を構築する

企業は、生成AIの成果物を公開前に必ずチェックする体制を作るべきです。

AIの生成物には、誤情報や偏見、著作権侵害のリスクが含まれるためです。

専門部署や担当者が、内容の正確性や表現の妥当性を確認する工程を設けます。

このファクトチェック体制が、企業の信頼性を担保する上で重要な役割を果たします。

.png)

5:利用するAIサービスの利用規約とセキュリティを確認する

企業は、利用する生成AIサービスの規約を十分に確認することが大切です。

サービスごとに、入力データの取り扱いや著作権の帰属などが異なるためです。

自社のセキュリティポリシーと照らし合わせ、安全だと判断できるサービスを選定します。

安易なサービス選択が大きな問題につながる可能性があるため、導入前の確認は不可欠です。

.png)

自社での対策に限界を感じたら専門家への相談もおすすめ

ここまで解説した対策を、すべて自社だけで完璧に行うのは容易ではありません。

どのAIサービスを選ぶべきか、ガイドラインの内容は適切かなど、判断に迷う場面も多いでしょう。

このような場合、専門家の知見を借りることもおすすめです。

AI活用の第一相談所を担う「クラベルAI」では、AIの活用を考えている方と専門家とのマッチングサービスを展開しています。

AI活用における「誰に・何を・どう聞けばいいの?」というところからAIを使った大規模開発まで、何度でも無料で相談可能。

AI活用のことで何か気になることがある方は今すぐ無料相談をご活用ください。

なお、電話相談(03-6826-0562)も可能です。

.png)

生成AIの倫理問題を把握して安全に活用しよう

生成AIは、ビジネスに大きな変革をもたらす強力なツールです。

その恩恵を最大限に受けるためには、倫理的なリスクへの備えが欠かせません。

この機会に自社の利用体制を見直し、安全な生成AI活用の一歩を踏み出しましょう。

もし生成AIの活用に不安があれば、専門家への相談も有効な手段です。

クラベルAIでは、AI活用に関する無料相談を受け付けています。

「誰に・何を・どう聞けばいいの?」というところからAIを使った大規模開発まで、何度でも無料で相談できるので、AI活用をお考えの方はぜひ一度お問い合わせください。

\AIの導入・開発・相談なら【クラベルAI】に相談しよう!/