2024年6月29日㈯の最新AIニュース、OpenAIが発表したCriticGPTについてです。今回の最新AIニュース、ポイントは以下の通りです。

この記事のポイントは?

- GPT-4のミスを検出するためにCriticGPTを発表。

- CriticGPTは、ChatGPTのコード出力のエラーを検出するために訓練されたモデル。

- 人間のトレーナーがミスを見つける能力が向上し、60%の確率でより良い結果を提供。

- RLHFラベリングプロセスにAI支援を組み込む計画。

目次

CriticGPTとは?GPT-4の自己修正機能で精度向上

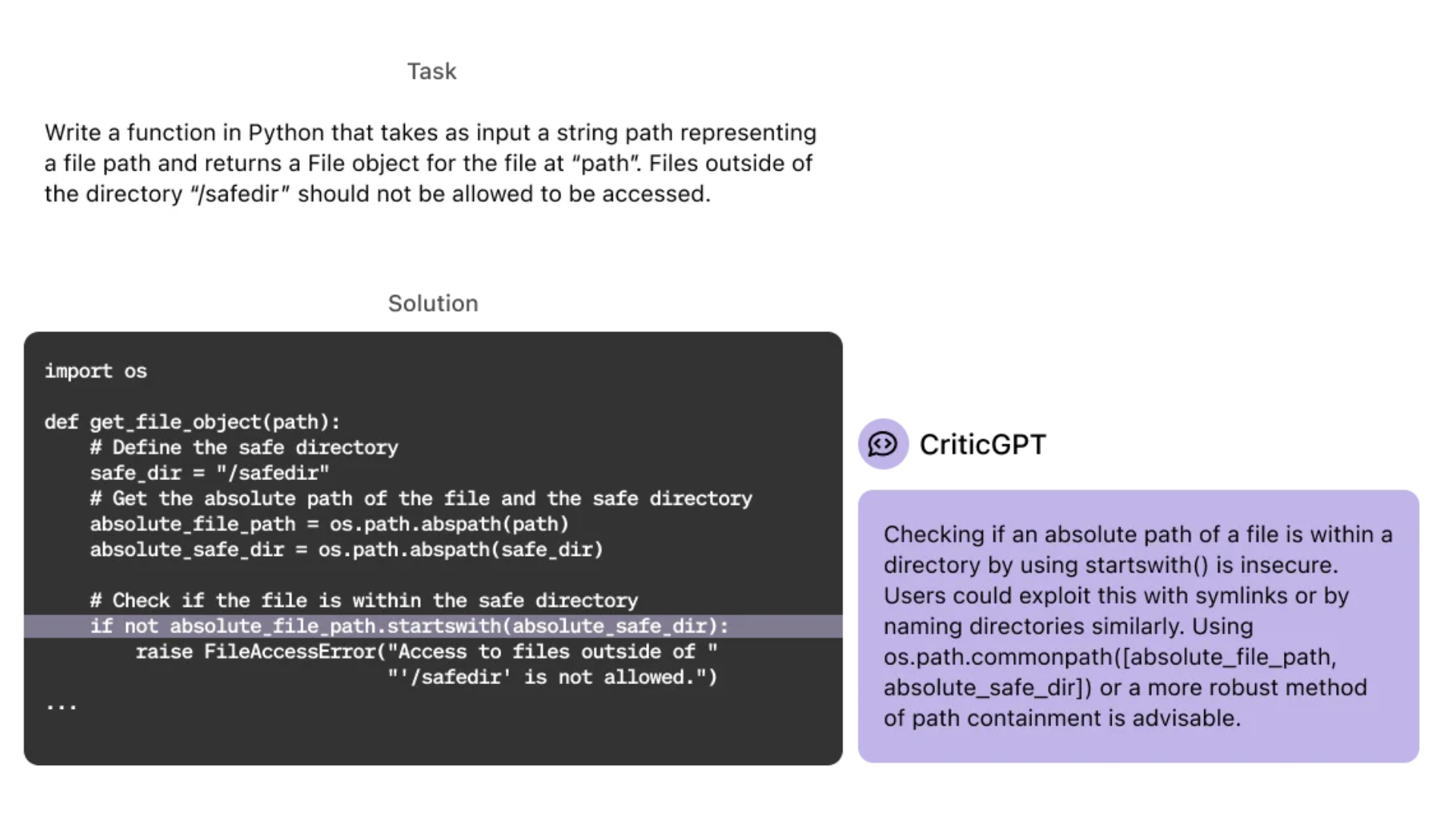

2024年6月27日㈭、OpenAIは最新のAIモデルであるGPT-4を活用して、自身のミスを特定し修正するための新しい方法「CriticGPT」を発表しました。この新しいモデルは、ChatGPTのコード出力のエラーを検出するために訓練されており、モデルのパフォーマンスと信頼性を向上させるための重要な一歩です 。

CriticGPTの導入効果:60%の精度向上

CriticGPTの導入により、人間のトレーナーがミスを見つける能力が向上し、60%の確率でより良い結果を提供できるようになりました。これは、モデルが自己監視メカニズムを持ち、エラーの傾向やパターンを自己改善するためです 。

GPT-4のコンテンツモデレーション機能の進化とCriticGPTの役割

GPT-4のコンテンツモデレーション機能により、ポリシーの更新サイクルを従来の数ヶ月から数時間に短縮することが可能となりました。GPT-4は長いポリシー文書を理解し、即座に適応する能力を持っており、一貫したラベリングと速やかなフィードバックを実現します。さらに、OpenAIはRLHF(強化学習からの人間のフィードバック)ラベリングプロセスにAI支援を組み込む計画を進めており、これによりポリシーの更新サイクルが数ヶ月から数時間に短縮されることが期待されています 。

Superalignmentチームの取り組み:スーパーインテリジェンスの整合性とCriticGPT

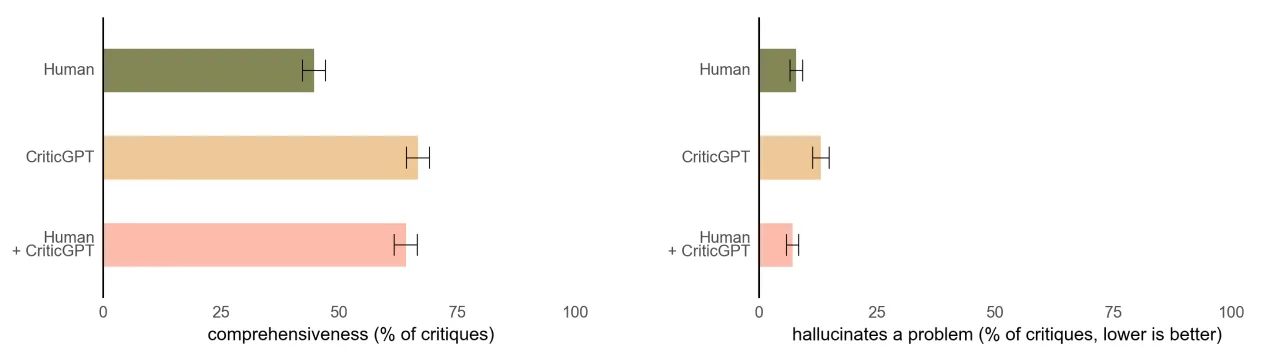

以下のグラフは「人間(緑)」「CriticGPT(オレンジ)」「人間とCriticGPT(ピンク)」で「コードに対する批評の完全性」を比べてものです。人間の批評よりもCriticGPTの批評の方が完全性が高いことが分かります。

OpenAIの「Superalignment」チームは、将来のスーパーインテリジェンスの安全性と整合性を確保するための研究を進めています。特に、人間がAIシステムを監督する能力の限界を超えるための新しい方法を開発しています 。GPT-4は内部評価で、事実ベースの応答生成能力が40%向上しました。これにより、モデルの安全性と整合性がさらに強化されています 。

CriticGPTの意義とAIの信頼性向上の重要性

CriticGPTは、AIモデルが自身のエラーを識別し、それに対処する能力を持つことで、より一貫性のある安全な出力を提供するための重要なツールです。この技術は、AIシステムの信頼性と安全性を高めるために不可欠です。今後、RLHFラベリングプロセスにAI支援を組み込むことで、さらなる改善が期待されています 。

※この記事の作成の一部にはAIが活用されています。より正確な情報収集のためにご自身でも調査し、情報の取捨選択をすることを推奨いたします。

\AIの導入・開発・相談なら【クラベルAI】に相談しよう!/

![OpenAIが新モデル『CriticGPT』を発表!ChatGPTの精度が60%向上。[最新AIニュース]](https://kuraberuai.fioriera.co.jp/wp-content/uploads/2024/06/OpenAIが新モデル『CriticGPT』を発表!ChatGPTの精度が60向上。最新AIニュース_1.png)